Après une longue absence, la suite de la série sur l’audionumérique se penchant sur les conséquences du théorème Shannon dans la chaine d’acquisition et restitution : antialiasing, filtres sinx/x et un exemple d’erreur conceptuelle : la méthode utilisée par Wadia.

Jipi

Impeccable…D’autres marques ont accompagné Wadia dans cette niche marketing, je pense à Denon et à Pioneer. Chacun a sa petite cuisine qui se retrouve dans les mesures qui sont caractéristiques.

Commentaire par Thierry Teepee Prévost — décembre 30, 2017 @ 12:43

Etant passionné par la Hi-Fi mais n’ étant pas un crac en math ni en électronique je trouve les vidéos passionnantes et surtout assassines sur les mythes de l’audio . Mon avis qui n’ engage que moi et à travers mes différentes expériences depuis les années 70 ( je commence à devenir un vieux dinosaure ) et que la Hi-Fi a fait beaucoup de progrès mais est trop victime des modes ou dogmes . Le haut de gamme a par contre beaucoup dérivé selon

moi vers des démonstrations de technologie pure et de maitrise des matériaux nobles ou exotiques et presque toujours au dépend de la musicalité et des clients . Mais il est vrai aussi que plus un produit est coûteux moins les frais de recherches et de productions pourront être amortis par une grande production . J’ essaie de combler mon retard sur les vidéos et attends avec impatience les prochaines .

Tous mes encouragements et tous mes meilleurs voeux pour Jipihorn .

Commentaire par TREMBLAIS Philippe — décembre 31, 2017 @ 5:35

Très bonne vidéo encore une fois. La NRDS avait fait de la publicité tapageuse sur Wadia et autre Denon (très haut de gamme, je ne me souviens plus du modèle) où l’on voyait effectivement le fameux signal sans oscillations. Ces lecteurs étaient vendus une fortune et le sont toujours d’ailleurs.

Une petite démo aurait été souhaitable ne serait-ce que pour convaincre tout le monde par la preuve: un wadia vs un lecteur grand public équipé d’un DAC sur-échantillonné.

Un petit aperçu rapide sur le sujet:

https://www.espace-cubase.org/page.php?page=appaudiojmp1

Commentaire par FRANCIS LIBRE — janvier 1, 2018 @ 1:21

Bonjour, je pense que le Denon que vous citez, est le DA-s1 et DP-S1.Je ne suis pas assez qualifié pour donner un avis , mais je suis un peu étonné de la part d’une firme comme Denon, qui à ma connaissance ,a été un des précurseurs en audio numérique. Il ont sortie les premiers enregistrements numériques je pense en 1973. Il serait dans l’erreur donc, étonnant. Se base t’il exactement sur le principe de Wadia? La dernière des choses, est ce réellement audible? La différence audible entre deux lecteurs cd, niveaux parfaitement égalisés, est extrêmement difficile à entendre si pas infaisable. Merci de vos réponses, et meilleurs voeux pour 2018.

Commentaire par Triolet — janvier 3, 2018 @ 2:01

Bonjour,

Le peu de choses que l’on peut lire sur le premier processeur « Alpha » de Denon dans ces appareils fait plutôt penser à un circuit qui requantifie les signaux numériques sur 20 bits en appliquant un dither pour réduire les erreurs de troncature. A l’époque, il me semble que ce n’était pas courant (un lecteur de CD Carver de 1985 introduisait cependant déjà du dither pour linéariser la conversion de signaux de très faibles niveaux sur les premiers bits) et que c’est seulement par la suite que des DSP de filtrage numérique dédiés à lecture des CD ont incorporé ces fonctionnalités (NPC SM5842AP et Sony CXD2567). Ces Denon remontent au début des années 90, ne l’oublions pas.

Commentaire par Scytales — janvier 4, 2018 @ 12:04

Bonsoir Scytales, effectivement cela remonte à pas mal d’années, c’est une autre époque.En numérique je ne m’y connais pas assez pour donner un avis sérieux. Mais Denon est une firme très sérieuse, il n’y a cas regarder la série sensitive.

Commentaire par Triolet — janvier 4, 2018 @ 12:52

L’ancien système Alpha de Denon n’est pas un simple ajout de dither, c’est bien un recalcul d’échantillons intermédiaires qui arrondit les angles des signaux et ne laisse aucun escalier tel qu’on les voit sur les signaux de très faible amplitude. Le résultat est la reproduction d’une sinusoïde parfaite à -90dB et 1kHz, par contraste avec une méthode sans calcul d’échantillons où le signal a l’allure de créneaux positifs et négatifs. Pour les signaux différents d’un sinus à 1K et -90dB, on voit des escaliers qui sont arrondis par ce système de calcul. A l’écoute des signaux, on constate bien que les parasites se retrouvent spectralement déplacés vers les graves, avec un spectre variable avec le contenu du signal. Il n’y a aucun dither ajouté dans l’ancien système Alpha, ce qui rend la sonorité du procédé extrêmement audible, dans la mesure où on dispose de musiques enregistrées aux alentours de -80 dB et qu’on les reproduit à pleine échelle, avec le volume à fond ou même plus. Sinon, on n’entend pratiquement pas de signal aux alentours de -90dB à volume normal. Ce qui fait qu’à la finale, c’est quasiment impossible de faire une différence à l’écoute entre un convertisseur conventionnel de bonne qualité et le Denon Alpha. Je n’ai plus en mémoire la ref du circuit Alpha de Denon, mais il a bel et bien existé. Je pourrais la retrouver d’ailleurs. (Mais cela n’a pas un grand intérêt).

Commentaire par teepee11 — janvier 5, 2018 @ 5:13

Bonjour,

Arrondir un escalier… Voilà que nous sombrons en pleine digression audiophile sans fondement technique.

Le signal numérique n’est pas un escalier ; c’est une représentation fausse du signal utilisée par les affichages « low cost ».

Pardon pour la forme mais le message doit être sans ambiguïté : les suites d’explications évoquées ici dans les commentaires sont des foutaises.

Mettre ainsi en avant le soi-disant sérieux d’un vendeur de produit audio c’est user d’argumentum ad verecundiam.

Comme l’explique Jipi de manière détaillée, argumentée et factuelle, la seule méthode valable pour reconstituer un signal échantillonné régulièrement dans le temps passe par le sinus cardinal.

Ce que proposent ces constructeurs, aussi « sérieux » soient-ils, amène à des usines à gaz qui ne fonctionnent pas correctement.

La quantification et le dithering c’est autre chose. L’information perdue lors de la quantification l’est définitivement et les méthodes de lissage rustinées produisent autant de distortion (à faible niveaux) ou de bruit que la simple troncature.

Le « dithering » ajouté par cette étape de requantification sur 20 bits n’arrange rien à l’affaire. C’est un mythe qui ne tiendrait pas devant un comité de relecture IEEE (voilà une référence sérieuse en traitement du signal).

Je ne doute pas que Jipi évoquera le moment venu la problématique de la quantification et je l’invite à tordre le cou à ces discussions pseudo technique sur « l’escalier » qui n’a aucune réalité.

Commentaire par Guillaume — janvier 6, 2018 @ 11:31

Je me demande si vous avez bien lu ma réponse. Oui l’arrondissement de signal (Le traitement DSP d’interpolation) est bien un procédé de marketing, on est bien d’accord. Mais on reste en plein dans le sujet, les Wadia etc bla bla bla.

Mais il ne faut pas donner de fausses infos non plus:

Les « escaliers » générés par les conversions, cela existe bien. J’ai vu ici et là sur l’Internet des commentaires affirmant que ces fameux escaliers n’existaient pas. C’est une erreur, simplement les auteurs n’ont probablement pas trouvé le moyen de les mettre en évidence. Je pense entre autres à un article de Thierry Martin qui met en ligne un article d’une autre personne qui fait cette expérience.

Je vous donne la méthode 😉

Il vous faut un oscilloscope basique, un préampli ayant un gain assez élevé, et un signal numérique donnant, après conversion, un signal analogique sous les -80 dB ( Comme le EIAJ CD-1, Plage 14, index 9 et 10). Bon visionnage! Et bonne année 2018.

Commentaire par teepee11 — janvier 6, 2018 @ 6:20

Allez, voilà un fichier, (c’est un FLAC) d’un sinus à 1kHz dont le niveau baisse par incréments, de 0 à -90 dB. Il ne reste plus qu’à l’envoyer dans votre convertisseur et regarder le signal en sortie en fin de fichier. Si vous êtes sages, je vous retrouverai une plage avec de la musique dont la pleine échelle est à -80 dB si je me souviens bien. Mais il faut que je cherche.

https://www.dropbox.com/sh/pelu0vbu23lk8ho/AABqKANNCvNz2NKjAh3ukzafa?dl=0

Commentaire par teepee11 — janvier 7, 2018 @ 1:09

Bonjour,

J’ai bien lu votre réponse, et la suivante.

Si par « escalier » vous voulez évoquer les effets de distortion de la quantification dès lors que l’on est en dessous de 6 bits de quantification, oui le phénomène existe et je maintiens mon propos : C’est n’est pas une interpolation qui permet de régler/atténuer le problème.

L’information est définitivement perdue.

Tenter une interpolation sur un bruit de fond (parce que c’est la réalité de ce l’on trouve en dessous de -80dB FS) c’est juste s’exposer un peu plus au phénomène de Runge évoqué par Jipihorn, sans le nommer.

https://fr.wikipedia.org/wiki/Ph%C3%A9nom%C3%A8ne_de_Runge

Quelle fausse information est-ce que je donne ? Ou Jipihorn peut-être ?

Un signal avec une pleine échelle de -80dB ? Qu’est-ce que cela signifie ?

Un enregistrement sur 4 bits !? C’est totalement absurde.

A mettre à la poubelle, avec l’ingé son qui a fait un mastering pareil.

Commentaire par Guillaume — janvier 11, 2018 @ 9:28

La fausse info est seulement d’affirmer que les célèbres « escaliers » n’existent pas, alors qu’on peut les voir sur un signal très faible.

Moi je suis globalement d’accord avec vous, il ne faut pas que vous vous trompiez de cible, oui le traitement DSP des signaux de façon à faire disparaître ces escaliers disgracieux à l’oeil est bien une opération marketing et oui le signal est de toute façon perdu. Pour info je me rappelle d’un commercial de chez Denon qui affirmait à qui voulait l’entendre que les informations perdues étaient bel et bien recréées, il n’y connaissait pas grand-chose et son seul objectif à l’époque était de vendre des produits. Cela valait quand même bien le coup que je mette le doigt dessus? Ca a existé, ça a vendu…

Un signal musical enregistré à -80dB à pleine échelle, cela a bel et bien existé, mais c’est sur un disque test, pas de panique. Et ce n’est pas du bruit de fond, on entend bien la musique sur fond de chute d’eau en cas d’ajout de dither, ou de chute de pierres en cas d’interpolation. C’est intéressant d’entendre cette différence, mais tout le monde n’est pas curieux c’est un fait (regrettable).

Commentaire par teepee11 — janvier 14, 2018 @ 7:36

Voilà, j’ai retrouvé cette plage de musique enregistrée (en réalité) à -60dB. Voilà qui peut mettre en évidence à l’oreille (et visuellement avec un oscilloscope) des différences entre divers convertisseurs D/A.

https://www.dropbox.com/sh/473lvc8jqmrzrxp/AAA-_qzTufeTynpXvDNw2OqZa?dl=0

Commentaire par teepee11 — janvier 14, 2018 @ 9:48

« La fausse info est seulement d’affirmer que les célèbres « escaliers » n’existent pas, alors qu’on peut les voir sur un signal très faible. »

Sauf que cette assertion s’appuie sur une fausse représentation du signal numérique. Oui il existe une représentation du signal « en escalier » mais cette représentation est fausse.

Il n’y a pas d’escalier parce qu’entre deux échantillons il n’y a RIEN ; il s’agit d’un train d’impulsions de Dirac et c’est vrai quelque soit la quantification et quelque soit la dynamique du signal.

Est-ce faux ?

Commentaire par Guillaume — janvier 15, 2018 @ 12:13

Les célèbres « escaliers » dont on parle, ceux qu’on peut voir de nos yeux avec un oscilloscope et écouter de nos oreilles grâce aux signaux de test que tout le monde peut récupérer aux adresses dans mes messages ci-dessus, sont des signaux 100% analogiques. Ce ne sont pas des points ni des valeurs numériques, c’est ce qui sort des prises de sortie de n’importe quel lecteur CD. Ce n’est pas une représentation fausse, (cela voudrait dire que cela n’existe que dans nos esprits en déroute…?), c’est un résultat matériel, un signal électrique. Il faudrait l’amplifier à quelques centaines de volts et mettre ses doigts dans les RCA pour se rendre compte du fait que ce n’est pas une vision de l’esprit, une « représentation ».

Il faudrait aussi savoir ce qu’on veut faire signifier au mot « représentation ». Si finalement il s’agit de la représentation analogique du fichier numérique, eh bien cette représentation n’a rien de fausse, elle existe vraiment et elle est parfaitement représentée par un oscilloscope branché au bon endroit, réglé comme il faut, et avec un regard désabusé sur l’écran. Ce sont des escaliers. Si vous avez l’occasion de faire le test, n’hésitez pas, et surtout si vous avez sous la main un Denon DA500, un DCD2700, un DA-S1… visionnez la plage de musique à très faible niveau, mon deuxième lien, vous pourrez voir de vos yeux des escaliers arrondis que je ne voudrais pas descendre un jour de verglas.

J’en ai parlé uniquement parce que, comme il s’agit ici d’une vidéo sur le traitement DSP d’interpolation de signal appliqué à l’audio, j’ai pensé qu’on pouvait parler aussi des essais divers tentés par la concurrence à Wadia. Il y a eu Denon avec leur Alpha, Pioneer avec le Legato Link, ceux-là pour diverses raisons je les ai mesurés et je les connais bien.

Commentaire par Thierry Teepee Prévost — janvier 15, 2018 @ 11:31

Bonjour,

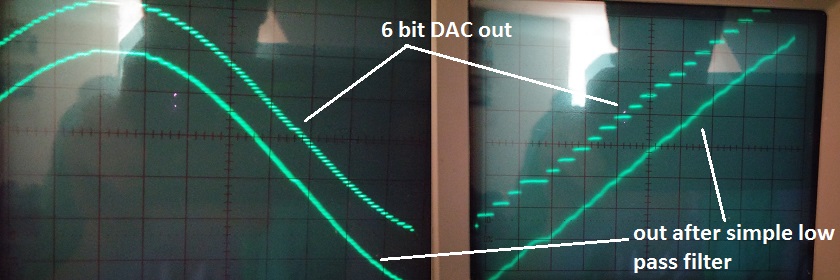

Voici ce que donne une mesure à l’oscilloscope de l’application d’un simple filtre passe-bas analogique du 2nd ordre en guise de filtre d’interpolation en sortie de CAN ; il n’y a plus d’escalier :

Je vous invite d’ailleurs à consulter le reste du site…

https://www.androidauthority.com/why-you-dont-want-that-32-bit-dac-667621/

Quand j’aurai la chance de trouver un peu plus de temps pour programmer un script de test, et si vous êtes sage, nous pourrons regarder l’effet du sur-échantillonnage / filtrage numérique utilisé en standard sur n’importe quel CAN moderne en laissant la possibilité de jouer avec les paramètres en toute transparence sur le traitement réalisé.

Au-delà du « problème de l’escalier à arrondir », surtout célèbre pour être une bêtise audiophile, il est mathématiquement et physiquement impossible de proposer une méthode d’interpolation qui permette de retrouver l’information perdue lors de la quantification d’un signal quelconque (dont la bande est bien sûr compatible de la Fe).

Il est possible, et même assez simple, de mettre au point une méthode qui permet de retrouver une sinusoïde qui a été quantifiée sévèrement mais dans tous les autres cas de signaux cette même méthode donnera des résultats moins bons que ceux de l’interpolateur de Shannon. Or la musique est, Dieu merci, autre chose qu’une seule sinusoïde stationnaire.

C’est un acquis et un fondement du traitement du signal ; Jipi l’a pourtant expliqué et martelé dans sa vidéo.

Il existe des techniques de restauration audio qui permettent d’introduire de la connaissance a priori sur le signal afin de reconstruire l’information perdue lors de la quantification mais il s’agit d’une tout autre classe d’algorithmes. Nous sommes loin de l’application temps-réel sur nos machines actuelles… alors en sortie de CAN (même de grande marque).

Voici un exemple qui donne une idée de la complexité et des limitations, en détail :

http://ieeexplore.ieee.org/document/810874/

Commentaire par Guillaume — janvier 20, 2018 @ 8:13

Bonjour Guillaume, mais oui nous savons tous cela, il n’y a pas de problème, on est bien d’accord. MAIS veuillez considérer que dans mes messages au dessus, je parle de l’aspect du signal A TRES FAIBLE NIVEAU. J’en ai parlé car c’est exactement cet aspect-là de la question, et pas un autre, que la marque Denon avec son système « Alpha » a tenté de traiter. Et on devisait à propos de diverses marques s’étant essayées au traitement de signal appliqué à l’audio jusqu’au ridicule dans des solutions à des non-problèmes.

La différence entre l’aspect des signaux à très faible niveau et à niveau plus élevé, est que dans le premier cas un changement de bit s’effectue très souvent après de nombreux cycles d’horloge, alors qu’à niveau plus élevé, il y a un changement par cycle d’horloge dans la plupart des cas. La conséquence est que, dans le premier cas, les Célèbres Escaliers ne sont pas intégrés par le filtrage car ils sont isolés temporellement.

Merci de m’avoir montré ces oscillogrammes, mais je les connais… non pas en ayant seulement surfé sur l’Internet, mais en ayant pratiqué moi-même ces montages jusqu’à la nausée. D’ailleurs je pense que tous le monde ici est capable de prédire le résultat d’un filtre passe-bas sur une résiduelle hors bande, moi compris je vous l’assure.

Il serait mieux que vous testiez vous-même un convertisseur X ou Y avec les signaux dont je vous ai fourni les liens. Tant que vous ne l’aurez pas fait ou que quelqu’un ne vous aura pas montré, vous resterez dans l’ignorance d’un détail auquel malgré tout …vous semblez attacher une grande importance.

Bonne continuation!

Commentaire par Thierry Teepee Prévost — janvier 21, 2018 @ 10:23

Allez, puisque vous avez été sages, voici quelques photos de copies d’écran qui datent de plus de 20 ans…! Ce sont des oscillogrammes de la même section musicale, pris en sortie directe de trois convertisseurs différents de lecteurs CD (J’en ai plein plein d’autres). Le premier est un convertisseur standard 16 bits sans dither, le deuxième le couple Denon DA-S / DP-S1 avec leur système Lambda (Pour les curieux qui se posaient des questions au dessus), et le troisième un ancien lecteur McCormack muni d’une mécanique et d’une électronique Philips, 16 bits + dither.

https://www.dropbox.com/sh/udwjahv1g6ahimu/AAA6GvkvRfW16FnyMSblBwN6a?dl=0

Les deux traces en haut et en bas sont les canaux gauche et droit, (ici le McCormack a sa phase inversée en sortie), et la trace au milieu est un signal 1kHz -90dB.

Vous pourrez voir l’effet d’un traitement DSP sur les signaux dans le cas de l’ensemble Denon, et du dither dans le cas du système Philips. Le résultat audible est très différent. Bien entendu, à niveau normal, la différence est reléguée à un niveau bien inférieur au niveau de perception de l’oreille. Ce sont tous de bon convertisseurs en écoute musicale.

Commentaire par teepee11 — janvier 21, 2018 @ 11:44

« DA-s1 et DP-S1 », oui c’est ça, malheureusement je n’ai pas gardé le numéro de la NRDS le concernant. En tout cas aujourd’hui les constructeurs grand public (Denon en tête) utilisent tous des DAC sur-échantillonnés avec des filtres numériques.

Bien sûr toute les marques renferment leurs petits secrets, markéting oblige.

Je me souviens d’une démo de Bassi, il y a fort longtemps, dans laquelle il faisait observer le phénomène d’aliasing sur un morceau de violon jouant des notes dans l’extrême aigu. On entendait effectivement le son « haché » du violon, mais Bassi s’était contenté de dire qu’on entendait le bruit de quantification. Seulement je ne me souviens plus des conditions de l’expérience, je sais simplement que le lecteur était un Studer A730. Il est possible que l’enregistrement lui-même ait été « atteint » d’aliasing…

Ce qui m’étonne, c’est que les lecteurs cd pro semblent rester basiques concernant la conversion du signal numérique:

http://www.tascam.eu/fr/cd-6010.html

Commentaire par FRANCIS LIBRE — janvier 3, 2018 @ 9:48

Encore merci ..

C’est croustillant ..

Te remercie de bousculer encore et encore ..

L’audiophilie se délecte de croyances ancrées par des articles (c’est édité donc c’est vrai) ultra-intéressants certes .. le matos, le matos … mais se remettre en question ….

J’ai 50 balais .. j’écoute beaucoup de musique .. mes amis aussi .. du live aussi, évidemment … Beaucoup sont encore figés sur des croyances ésotériques d’articles en couleur incidemment culpabilisants (si t’as pas cette ultime évolution qui remet en cause l’acoustique, tu n’y connais rien .. et en profiter pour faire de même avec son entourage inculte..)

j’ai les RDS et NRDS depuis 1992 jusqu’à … je donne tout à qui veut bien se déplacer vers Hyeres ..

c’est croustillant ..

L’ampli ultime câblé en l’air avec des transistors exotiques obsolètes tellement « triés » qu’ils n’existaient pas ..(ah merde ..!)

Des schémas à lampes ultimes (!) 845 boursoufflés de transfos – filtres – au prix d’une bagnole (en mono)

Les graves et le haut rendement (VOT)… etc …

Et le vocabulaire d’initié qui va avec … dureté .. musicalité (j’adore) … intégrité des timbres (pas mal) … qualité artistique (faut oser le melon) …

Mon fleuron : les pointes de « découplage » .. ces pointes font exactement l’inverse : elles transmettent par couplage la stabilité du support à ce qui est posé dessus simplement par leur masse réunie en un point … (un fakir sur 10000 pointes divise sa masse et se découple du support … laissons-en trois juste pour voir …)

Misère intellectuelle ..

Pour rester dans le numérique, j’aimerai bien un « takin’apart » de puce STmicro STA326 façon JP ..

Un passionné ..

Commentaire par hubert — janvier 3, 2018 @ 11:19

Bonsoir, le test de ces Denon a été aussi réalisé par la revue L’audiophile. Le n° 26 de octobre/novembre 1993. Par amusement j’ai téléchargé tous les numéros de cette revue, il y a déjà pas mal d’années. Vous les trouverez en tapant sur Google » Tous les numéros de la revue L’audiophile jbl vintage et new. » Cela peut-être intéressent de retrouver certains articles. Pour les wadia, il y avait une chose qu’ils avaient qui étaient très bien, c’était leur mécanique Teac vrds. C’était probablement ce que l’ont faisait de mieux à l’époque., et d’une fiabilité à toute épreuve.

Commentaire par Triolet — janvier 3, 2018 @ 11:28

Attention avec la VRDS, il n’y a plus de KSS151A, épuisé depuis de nombreuses années. (Le bloc optique). Et à première vue il y a pas mal de blocs HS qui circulent sur Ebay.

Commentaire par teepee11 — janvier 5, 2018 @ 5:17

Bonjour, oui ces kss151A sont épuisé, comme par ailleurs les philips (entres autres celles placées sur les Revox, studer etc…). Pour le dire plus clairement je possède un Teac Vrds 25 depuis 1998, et jamais eu le moindre problème excepter une courroie pour l’ouverture du tiroir. Si un jour la diode me lâche et bien il aura fait son temps.

Commentaire par Triolet — janvier 5, 2018 @ 6:07

Tant mieux, c’est une bonne machine, c’était surtout pour que des lecteurs le sachent avant de fantasmer sur les VRDS.

Commentaire par teepee11 — janvier 6, 2018 @ 6:23

Attention au mythe de la mécanique de précision en numérique: là encore, il ne faut pas penser comme en analogique. S’imaginer qu’on puisse atteindre une lecture inférieure au micron (la taille des infos numériques étant de l’ordre du micron) est une illusion. Ce qu’on demande à une bonne mécanique cd s’est d’être fiable et pérenne. Idem en ce qui concerne les supports style SHMCD dont les argument commerciaux sont incompatibles avec l’idée même de la lecture des infos numériques (cf le précision des cuvettes inscrites dans la partie métallique du support…).

Commentaire par FRANCIS LIBRE — janvier 4, 2018 @ 4:19

Bonjour, je ne pensais pas à la lecture analogique, qui elle évidement est primordiale. Mais je ne pense pas non plus que toutes les mécaniques de cd se valaient. La mécanique des Teac a ceci de bien, c’est que le disque compacte est maintenu sur toute sa surface , et à plat, contrairement aux fixations en générale plutôt centrale simplement. Je pense, que c’était mécaniquement mieux réalisé, et extrêmement fiable, ce qui est primordiale. Mais pour le reste je suis d’accord avec vous. Je pense que le dématérialisé est bien également, et je vais probablement m’y mettre aussi. Mais je n’ai pas envie de me farcir tous ces serveurs informatiques avec tout le reste. Cela doit être réalisé correctement, ou bien c’est le bordel.

Commentaire par Triolet — janvier 5, 2018 @ 12:00

Oui, difficile de s’y retrouver dans cette jungle du numérique devenu le pilier du « libéralisme extravagant ». Donc dans ce vaste marché du mensonge et de propagande, il faut faire preuve d’esprit critique afin de ne pas se laisser enfumer:

http://www.lemonde.fr/pixels/article/2015/08/21/on-a-teste-la-musique-en-haute-definition_4711583_4408996.html

Quand à la réédition des cds, nous ne sommes même pas certains qu’ils ne proviennent pas de sources mp3 converties en format cd…

Commentaire par FRANCIS LIBRE — janvier 5, 2018 @ 12:59

Commentaire d’un des participants au blind test organisé par Le Monde…

« La différence est presque inaudible. Le plaisir est probablement contenu dans l’idée même d’écouter la musique en HD. Chez certaines personnes, ça suffit à trouver une forme de contentement. »

Tout est dit. La perception de la différence est directement proportionnelle avec la dépense…

Et ça, les fabricants de matériels fabriqués les soirs de pleine lune et recuits à la poudre de perlimpinpin l’ont bien compris. Depuis que la presse audio existe, chaque nouvelle génération d’ampli/enceintes/lecteurs, va « plus loin » que la précédente.

Logiquement, aujourd’hui, on devrait être au nirvana de la reproduction audio et entendre chanter les anges. Quelle foutaise!!

Commentaire par Luc — janvier 7, 2018 @ 12:34

Merci pour l’article du monde que je ne connaissais pas. C’est très instructif,et confirme ce qu’avait dit deux anciens membres qui ont travaillés pour la société Cabasse. Pas de différences entre de la Hd et Cd quand le master est le même.Ils confirmaient pour l’un d’entres eux en tout cas qu’il y a beaucoup de tripotages, et que l’on ne sais pas réellement ce que l’on achète, et que c’est parfois du véritable foutage de gueule.

Commentaire par Triolet — janvier 5, 2018 @ 4:11

A la lumière de la vidéo de Jipi sur les DAC indépendants, les lecteurs cds équipés de DAC affichent jusqu’à 32bits/192KHz. Est-ce vraiment nécessaire? Sachant que le matériel pro semble dépourvu de sur-échantillonnage. Quelqu’un a t-il des infos sur ce sujet?

Commentaire par FRANCIS LIBRE — janvier 6, 2018 @ 11:30

32 bits @ 192kHz à la diffusion ? Ou en interne pour insérer des traitements numériques ?

Commentaire par Guillaume — janvier 11, 2018 @ 9:39

L’explication apportée par jipihorn sur la nécessité de filtrer dans un DAC en sinus cardinal pour restituer fidèlement le signal numérisé est lumineuse et du coup me vient une hypothèse qui expliquerait pourquoi certaines marques (comme Sony ou TEAC) ont proposé ou proposent sur leurs lecteurs de CD ou leurs convertisseurs des filtres numériques qui s’écartent de la réponse en sinus cardinal.

Supposons de très vieux enregistrements numériques (sur les tout premiers CD, par exemple). Le filtre passe-bas anti-repliement avant numérisation est un filtre analogique qui n’est pas un brickwall parfait et dont la réponse impulsionnelle n’est pas celle d’un filtrage en sinus cardinal. Si lors de la conversion numérique-analogique, on ne filtre pas avec un passe-bas ayant une réponse impulsionnelle en sinus cardinal mais avec un autre filtre numérique ayant une réponse impulsionnelle identique ou en tout cas plus proche de celle du filtre passe-bas imparfait appliqué lors de la numérisation, on devrait se retrouver dans une situation qui permet de reproduire plus fidèlement le signal numérisé.

La possibilité de pouvoir sélectionner un filtre numérique ayant une réponse impulsionnelle qui s’écarte de l’idéal de la réponse en sinus cardinal devrait donc plutôt être vue comme un moyen de pallier les imperfections du filtrage passe-bas à la numérisation des très vieux enregistrements numériques. Un peu comme un inverseur de phase sur un préampli permet de corriger une erreur de branchement d’un microphone à l’enregistrement ou une inversion accidentelle lors de la production d’un disque. Une fonction dont on a rarement besoin mais qu’on est bien content d’avoir le jour où on rencontre un problème pour pouvoir malgré tout écouter dans de bonnes conditions le disque qui en est affecté.

Qu’en pensez-vous ?

Commentaire par Scytales — janvier 6, 2018 @ 4:22

Dès que l’on s’écarte du sinus cardinal l’échantillonnage détruit de l’information (ou rend impossible de la retrouver).

Il n’est pas possible de corriger a posteriori le recouvrement spectral.

De plus, les fabricants de lecteur n’ont aucune autre indication que la normalisation du format pour savoir comment se comporte le filtre d’un enregistreur… Qui laisse beaucoup de zone inconnue

Commentaire par Guillaume — janvier 11, 2018 @ 9:35

Quelques infos sur le traitement du signal numérique:

Cliquer pour accéder à cours_convertisseurs.pdf

Commentaire par FRANCIS LIBRE — janvier 7, 2018 @ 7:02

Et là:

http://www.thdstudio.com/Conversion-Delta-Sigma.htm

Commentaire par FRANCIS LIBRE — janvier 7, 2018 @ 7:04

une super video

et des questions

comment font les constructeurs de matériel audio-pro pour ne pas mettre trop de latence avec ADC, DAC et leurs filtres respectifs ?

je pense au processeur de sono ( DCX2496, Mini DSP Lake …) et aux consoles numériques destinées à un usage live

pas question d’introduire trop de retard sans quoi les musiciens ressentiront ce retard dans les retours

si console numérique il faut autant que possible traiter en numérique du préampli à la sortie de processeur

pour une prochaine video

pourrais tu décortiquer les transmissions entre périphériques

vu sur le www que les liaisons USB sont susceptibles de laisser passer des données corrompues sans correction

Commentaire par michel29 — janvier 11, 2018 @ 10:43

un oubli

les liaisons USB utilisées pour un flux de data audio

alors que d’autres données seront dûment vérifiées en parité ( copie de données vers ou depuis un support de stockage)

Commentaire par michel29 — janvier 11, 2018 @ 10:44

Bonjour,

À la visualisation de cette vidéo je me suis fais la réflexion comme quoi l’élément important pour avoir une bonne reoncstruction c’est la qualité du filtre passe-bas de sortie. Mais Peut on retrouver sur no dac (et lecteurs cd) et éventuellement l’amélioré ?

Commentaire par gW — janvier 15, 2018 @ 2:54

Bonjour,toujours agréable de regarder vos vidéos,une question, une mesure d’enceinte doit elle coller avec l’impulsion? PS peut on vous envoyer des documents d’études ,dans l’affirmative à quelle adresse? Merci

Commentaire par jean philippe martin — janvier 20, 2018 @ 12:00

» Mais je ne pense pas non plus que toutes les mécaniques de cd se valaient ».

En effet, les constructeurs sont peu loquaces lorsqu’il s’agit d’aborder le sujet relatif à la fiabilité de leurs mécaniques, ils préfèrent s’étendre sur l’argument « numérique », qui de toute manière s’étend sur des considérations subjectives… Une vidéo sur « qu’est-ce qu’une bonne mécanique cd » serait peut-être la bienvenue??

Commentaire par FRANCIS LIBRE — février 12, 2018 @ 2:32

La démat n’apporte rien plus au niveau qualitatif, elle permet de ranger ces cds dans des cartons et de les mettre à la cave. C’est un peu comme une bibliothèque sans livre. Tout cela change le rapport à la culture en général: la valeur sentimentale disparaît au profit de la virtualisation de l’humanité. Un monde étrange qui autorise tous les excès, en dehors du petit plus qu’il donne au commun des mortels.

Commentaire par FRANCIS LIBRE — février 21, 2018 @ 12:18

Bon, ok, vive la démat, il faut vivre avec son temps. Mais où est Jipi? Ne dites pas qu’il a été dématérialisé lui aussi!?

Forr n’est plus là, que ce passe t-il? Il faudrait lancer un appel à témoin!

Commentaire par FRANCIS LIBRE — avril 21, 2018 @ 10:25

Un retour sur le lecteur cd et sa mécanique dont on parle peu:

http://vintage-audio-laser.com/La-technique-du-lecteur-CD-page-1

En ce qui concerne le traitement des données, le principe adopté par la majorité des constructeurs d’aujourd’hui est: le suréchantillonnage (le filtre numérique), le filtre analogique passe bas à pente douce, puis le dither et ça fonctionne très bien pour peu cher.

La solution wadia est une erreur conceptuelle comme le dit Jipi et c’est surtout une manière de dire que « je ne fait pas comme les autres » en utilisant un sophisme bien connu: l’effet Pangloss.

D’une manière générale, le commerce audiophile et numérique utilisent des tas de bias cognitifs destinés à déclencher un effet placébo chez l’acheteur et donc le faire consommer inutilement.

Un exemple frappant, puisqu’on parle du lecteur cd, c’est le mythe de la mécanique de précision s’apparentant à celle de la lecture analogique. L’expérience simple de cet utilisateur réduit à néant ce mythe pour celui qui n’a pas compris comment fonctionne un lecteur laser:

« Les performances du mécanisme optoélectronique et de correction d’erreurs sont telles que même sur un Cd en vibration on ne perd pas de bits de lecture !!!! aussi incroyable que cela puisse paraître.

Dans ces conditions les drives à prix élevé ne sont que du pur marketing.

Pour preuve: une fois je suis tombé sur un dvd mal usiné que j’ai mis dans un lecteur à 25 € le défaut était tel que le lecteur vibrait comme un marteau piqueur et pourtant à l’image il ne manquait pas un seul pixel et le son était normal dans les haut-parleurs (dans la pièce il y avait le bruit du lecteur ! ) donc dans les pires conditions avec une quantité énorme d’informations (de la vidéo +de l’audio) il n’y avait pas d’erreur notoire! ».

Comptez le nombre de possesseurs de lecteurs CEC LTL(x) et autres machines à rêve, cherchant désespérément à faire réparer leur bouzin de luxe sur les forums…

Commentaire par FRANCIS LIBRE — Mai 9, 2018 @ 11:08

Il n’y a pas de dither après application d’un filtre analogique…

Après le filtrage numérique sur-échantillonné non plus, d’ailleurs, si les requantifications intermédiaires sont réalisées correctement.

Commentaire par Guillaume — Mai 9, 2018 @ 12:40

Tiercé dans le désordre… méa culpa.

« Le filtrage numérique permet donc de supprimer l’aliasing, et de diminuer le bruit de quantification, sans le supprimer. Même si celui-ci n’est pas audible, il engendre de la distorsion par intermodulation et un échauffement des composants. Il peut aussi perturber la chaîne d’amplification et détériorer les haut-parleurs du système acoustique. Un artifice consistant à injecter un signal bruité (« dither ») de même amplitude que le bruit de quantification permet de palier ce phénomène. »

Commentaire par FRANCIS LIBRE — Mai 9, 2018 @ 2:06

Si Teepee 11 pouvait nous fournir des exemples d’oscillogrammes à 1KHz/-90dB sur des lecteurs récents ce serait sympa de sa part…

Commentaire par FRANCIS LIBRE — Mai 9, 2018 @ 2:24

Polémiquer sur un signal à -90dB n’a effectivement pas de sens, mais tout ce qui peut éviter de détériorer la chaîne d’amplification est salutaire. La musique étant composée en majorité de transitoires, il serait plus important de se pencher sur l’étude de la distorsion d’intermodulation transitoire dans les circuits numériques et analogiques.

Commentaire par FRANCIS LIBRE — Mai 9, 2018 @ 4:14

Le dithering est utilisé en mastering quand il s’agit de requantifier un signal (24->16 par exemple), lorsque le résultat final est gravé sur cd, puis on applique un noise shaping pour rejeter le bruit aléatoire vers une bande de fréquence non audible. Quelques applications pratiques:

https://fr.audiofanzine.com/mastering/editorial/dossiers/le-dithering-au-mastering.html

https://www.retifweb.net/?var=10077&part=13

https://www.fruityclub.net/tutoriels-flstudio-organiser-parametrer/le-dithering/

Pour le lecteur cd, il y a polémique, car en effet, entendons nous une différence entre un classique 16/44 et les autres types de conversions que nous a présenté Teepee11? Dommage que Teepee ne nous ait pas montré ce qui ce passe dans le domaine fréquentiel sur ses trois exemples, on y aurait vu avec l’application du dither, une remontée du plancher de bruit et la disparition de pics dus au bruit de quantification.

http://musiq-audiophile.blogspot.fr/2010/03/de-linfluence-du-bruit-sur-la.html

Maintenant est-il possible que l’absence de dither provoquerait « l’échauffement des composant » à cause de la distorsion d’intermodulation produite par le bruit de quantification résiduel?

En tout cas, même si les lecteurs cd utilisent le dither et le noise shaping, on ne s’en plaindra pas, car pour moins de 200 euros, on a une platine qui fonctionne parfaitement.

Commentaire par FRANCIS LIBRE — Mai 10, 2018 @ 3:15

Alors? Erreur conceptuelle de la part de Wadia ou opération markéting fort coûteuse pour l’acheteur? La question mérite d’être approfondie.

Je me souviens d’une publicité de Wadia dans la NRDS qui montrait deux photos identiques d’un œil: une normale sous laquelle était inscrite la légende « le son Wadia » et l’autre pixelisée sous laquelle était inscrit « son d’un lecteur X ».

L’œil en question était celui d’une femme maquillée…

Commentaire par FRANCIS LIBRE — Mai 11, 2018 @ 10:07

J’attendais la vulgarisation de Jipi pour m’appuyer dessus mais comme elle tarde à venir je me lance.

Lorsque la dynamique du signal est grande devant le pas de quantification (en amplitude, à chaque échantillon) l’erreur de quantification se comporte comme un bruit blanc suivant une loi uniforme.

De manière intuitive, cela revient à dire qu’à chaque instant le signal tombe « au hasard » entre deux graduations de l’échelle de quantification.

Ce modèle mathématique est validé théoriquement (convergence d’une loi type Bennett vers la loi uniforme) et sur des mesures réelles par des tests statistiques qui vont bien au-delà de notre perception sonore nous permet de discriminer ; dans des conditions normales d’écoute il n’est même pas audible de toute manière.

L’erreur de quantification peut alors être traitée comme une source de bruit additif indépendante du signal numérisé lui-même.

Pour donner des ordres de grandeurs ; lorsqu’un signal audio est quantifié sur 4 à 6 bits (pleine échelle) alors l’erreur de quantif se comporte comme un bruit. Sur 16 ou 24… On a de la marge.

Avec une quantification moins fine, l’erreur n’a plus ce comportement de bruit et l’on retrouve une distorsion corrélée au signal (franchement audible).

On le remarque sur des enregistrements avec un niveau trop faible, ou sur la queue d’une réverbération qui meurt en grinçant, etc.

Le problème risque d’apparaître dès lors que l’on augmente le pas de quantification d’un signal déjà numérisé (i.e. que l’on réduit le nombre de bits).

Cette opération est opérée, par exemple, lors du mastering final avant gravure vers un CD pour passer, le plus souvent, de 32bits virgule flottante à 16bits virgule fixe.

Pour éviter le risque d’une distorsion audible causée par la requantification sur un passage « silencieux » ou faible d’une piste audio (et seulement à ces moments là), on ajoute une légère perturbation au signal pour s’assurer que l’erreur de quantification retrouve le comportement attendu et acceptable (i.e. le bruit uniforme décorrélé du signal numérisé).

Cette perturbation, c’est un bruit en plus que l’on ajoute avant le requantification. Le dithering ce n’est « que ça ».

(il existe des procédés qui réinjecte l’erreur de quantif en l’exploitant comme un générateur de nombres pseudo aléatoires).

Il a été démontré que le bruit additif triangulaire (deux tirages successifs suivant une loi uniforme) est la perturbation optimale pour décorréler l’erreur de quantification (je peux retrouver la publication, au besoin).

Les autres méthodes sont sous-optimales suivant ce critère.

Dans l’audio, on aime bien ajouter un bruit dont le spectre est creusé là où l’oreille est la plus sensible ; ça se discute (un compromis entre l’efficacité à réduire la distorsion et la perception du bruit ajouté).

A moins d’un traitement numérique particulier en sortie de CNA, il n’y pas lieu d’opérer un dithering : C’est fait au mastering avant diffusion / gravure sur CD.

Un signal audio sur un support numérique pour une diffusion de masse (CD, streaming, etc.) est toujours diffusé après dithering.

Du coup, l’interpolation polynomiale (ou autre) qui tente de reconstruire un signal vaguement sinusoïdal sur les petits niveaux n’a pas de sens : Sur les très faibles niveaux, le signal est essentiellement une somme de bruits (bruit à la prise, bruit de quantification, bruit du dithering).

Les « escaliers » n’en sont pas, et si l’on en rencontre c’est que le dithering n’a pas été appliqué et c’est une anomalie en audio.

En plus de l’erreur conceptuelle sur l’échantillonnage mis en avant par Jipi sur sa vidéo, le comportement particulier des interpolateurs polynomiaux sur des bruits provoque des artefacts haute fréquence.

Un signal sinusoïdale, ou proche, quantifié sur moins de 4 bits (à -90dB FS sur 16bits, par exemple) sans application de dithering ne révèle rien du tout.

Ce n’est pas un test pertinent : Il y a toujours application d’un dithering en sortie de mastering.

C’est même doublement trompeur :

– ça ne permet pas de mettre en avant le comportement erratique de ces interpolations exotiques sur des cas réels ;

– ça permet d’afficher des performances (supposées) supérieures sur des cas fantaisistes.

Pour résumer, sur les deux critères du traitement de l’échantillonnage et de la quantification ça ne fonctionne pas ou moins bien que les méthodes classiques.

D’un point de vue théorique et pratique c’est une erreur.

Commentaire par Guillaume — Mai 27, 2018 @ 1:42

Ce qui veut dire qui si le dithering est appliqué en mastering, il n y a aucune raison de l’appliquer à la lecture du support? Est-on certain que ces artefacts n’existent pas pendant la lecture?

Commentaire par FRANCIS LIBRE — Mai 28, 2018 @ 11:23

Bonjour,

Le dithering est une étape incontournable du processus de quantification dès lors que l’on veut garantir le comportement de l’erreur de quantification (bruit blanc uniforme décorrélé du signal d’intérêt).

Le principe fondamental est de perturber suffisamment et de manière aléatoire la troncature. Le bruit du dithering est donc injecté AVANT quantification, sinon c’est trop tard.

Il doit donc intervenir à la numérisation du signal analogique et/ou lorsque l’on réduit la résolution d’un signal numérique.

Il ne peut pas être appliqué a posteriori sur un signal déjà quantifié : C’est trop tard, le mal est fait.

Le signal musical numérique contient déjà l’erreur de quantification après application du dithering : Un signal audio de faible amplitude quantifié sans dithering est un signal mal quantifié.

Concrètement, côté production en studio, l’enregistrement, le mixage, les effets numériques divers et le mastering (compression de dynamique, en particulier) sont opérés sur un nombre de bits très supérieur au moyen de diffusion afin d’écarter tout artéfact audible dû à la propagation d’erreur numérique ou à une saturation numérique.

Une fois ces traitements réglés, l’étape finale du mastering consiste à requantifier le signal produit pour atteindre le nombre de bits ciblé ; c’est à ce moment (et pas un autre) que le dithering rentre en jeux pendant la requantification :

– Avant c’est sans objet : on travaille sur l’ensemble des traitements numériques sans réduction du nombre de bit ;

– Après c’est trop tard : on ne peut plus corriger le comportement du bruit de quantification.

« Ce qui veut dire qui si le dithering est appliqué en mastering »

Le dithering DOIT être appliqué au moment de l’étape finale de requantification d’un mastering.

« il n y a aucune raison de l’appliquer à la lecture du support? »

Ca n’a même aucun sens : Si ça n’a pas été fait avant gravure c’est irrécupérable.

« Est-on certain que ces artefacts n’existent pas pendant la lecture? »

Sauf travail amateur niveau débutant moins, ça n’existe pas sur le signal gravé / diffusé.

En interne dans le CAN, si des traitements numériques sont introduits dont une étape de requantification alors oui un dithering doit être appliqué mais c’est à la discrétion du fabricant et c’est sans garantis d’une meilleure fidélité (au contraire même).

Des traitements un peu astucieux peuvent aussi tirer profit du fait qu’un dithering ciblant du 16 bits (sur CD) a déjà été appliqué : Si les traitements numériques sont réalisés en 32 bits puis que le signal est requantifié en 24bits, l’erreur initiale des 16 bits suffira à garantir que la requantification sur 24 bits n’introduira pas d’artéfact.

En clair, moyennant quelques précautions, on peut faire du 16 bits (CD) ==> 32 bits (traitement) ==> 24 bits sans dithering.

A voir en fonction du traitement ;

– pour une équalisation légère, oui le signal doit conserver assez « d’agitation » ;

– pour un fading numérique où le niveau du signal tends vers 0, ça ne fonctionne pas il faut passer par le dithering.

Commentaire par Guillaume — Mai 29, 2018 @ 10:25

« Pour résumer, sur les deux critères du traitement de l’échantillonnage et de la quantification ça ne fonctionne pas ou moins bien que les méthodes classiques.

D’un point de vue théorique et pratique c’est une erreur. »

Quelles sont les « méthodes classiques » en lecture numérique? Merci d’éclaircir ce point.

Commentaire par FRANCIS LIBRE — Mai 29, 2018 @ 6:07

Les méthodes classiques présentées par Jipi.

Pour la quantification, la partie détruite l’est définitivement et il n’y a pas de solution de restauration magique ou performante dans tous les cas de figure de l’audio.

Ces techniques consistent toutes à introduire une connaissance a priori sur le signal à restaurer (pour compenser ce qui est perdu) : si cette information n’est pas la bonne a posteriori le signal n’est pas restauré et est même dégradé

Pour l’interpolation, il faut essayer de tendre au maximum vers le filtre idéale explicité par Shannon. C’est la seule voie.

Les techniques d’implémentations sont diverses et l’innovation trouve toute sa place mais l’objectif reste de s’approcher du filtre d’interpolation idéale.

Les solutions qui s’en écartent sont immanquablement moins performantes.

Le sur-échantillonnage suivi d’un filtrage numérique avant d’attaquer le filtre analogique est une solution efficace qui permet de s’approcher du filtre idéale.

Je n’ai pas revisionner la vidéo mais il me semble que Jipi présente cette solution d’implémentation.

Il faut bien réaliser que le cadre théorique de Shannon est fondamental pour le traitement du signal numérique et de l’information.: A Mathematical Theory of Communication de 1948 avec 3 démonstrations qui plantent le cadre de ce que l’on peut faire et, surtout, de ce que l’on ne peut pas faire :

– le théorème d’échantillonnage de Nyquist-Shannon ;

– la limite théorique de la compression (sans perte) ; ==> il est vain d’essayer d’aller au-delà de cette limite

– la capacité maximale d’un canal de transmission. ==> il est vain d’essayer de transmettre plus d’information (au sens de Shannon) que ce que permet un canal.

Les deux derniers théorèmes ne sont pas sans lien avec le problème de la restauration et de la perte d’information due à la quantification…

C’est aussi ce cadre qui permet de démontrer que si l’on veut atteindre les taux de compression du mp3 pour l’audio ou du jpeg pour l’image, alors il faut accepter de perdre une partie de l’information totale. Mais c’est un autre sujet.

Commentaire par Guillaume — Mai 29, 2018 @ 11:07

Merci Guillaume pour ces réponses éclairées. Est-ce à dire que le vieux TDA 1540 était ce qu’il fallait et pas plus comme CNA?

Concrètement les lecteurs cd récents n’ont pas vraiment d’utilité, d’ailleurs je me demande si les lecteurs cd pros, enfin pour le peu qu’il en reste, font du dithéring.

Commentaire par FRANCIS LIBRE — Mai 30, 2018 @ 7:09

C’est drôle: depuis la démat, le cd en prend plein la gueule, principalement en ce qui concerne sa durée de vie qui a été largement revue à la baisse. Et non seulement ça, il est « écrasé » par le retour du vinyle, qui est le plus mauvais support audio qui existe. Mais que nenni, la société marchande impose ses exigences.

Commentaire par FRANCIS LIBRE — juin 11, 2018 @ 4:16

Bonjour Jipi, j’ai une question bête, as tu déjà écouté un wadia de l’époque de don wadia,? de son vivant j’entends …

Commentaire par lazennec — décembre 18, 2020 @ 9:59